Spark on yarn 与 standalone配置差距不大,Spark主要是计算框架,而不是资源调度框架,所以本身提供的资源调度并不是它的强项,on yarn 将资源调度任务给了yarn。

安装

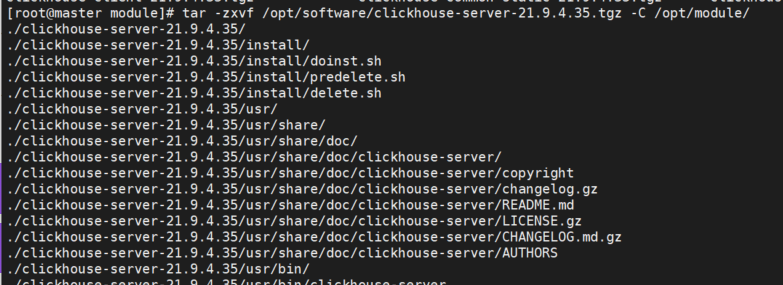

解压spark

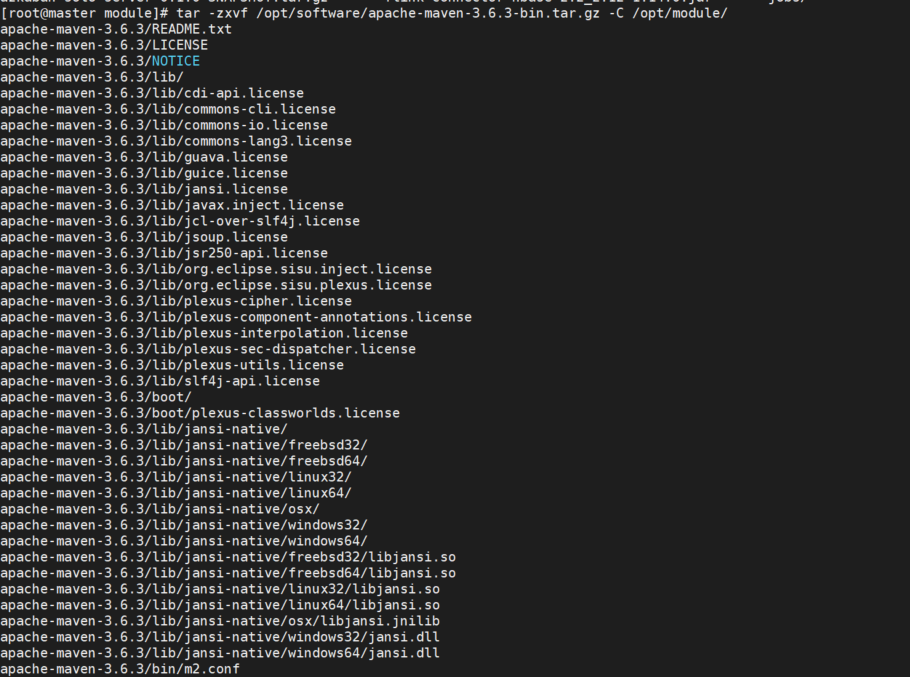

tar -zxvf /opt/software/spark-2.1.1-bin-hadoop2.7.tgz -C /opt/mv /opt/spark-2.1.1-bin-hadoop2.7 /opt/spark-2.1.1进入spark 根目录 打开conf文件夹 复制一份spark-env.sh

cp spark-env.sh.template spark-env.sh在spark-env.sh文件中添加JAVA_HOME、HADOOP_CONF_DIR或SPARK_CONF_DIR,:wq保存退出HADOOP_CONF_DIR或SPARK_CONF_DIR 配置为hadoop配置文件目录

export JAVA_HOME=/usr/local/jdk1.8.0_251

SPARK_CONF_DIR=/opt/hadoop-2.7.7/etc/hadoop/在profile中配置spark全局变量

export SPARK_HOME=/opt/spark-2.1.1

export PATH=$PATH:$SPARK_HOME/binon yarn 不需要执行start-all.sh

可以提交example 给spark

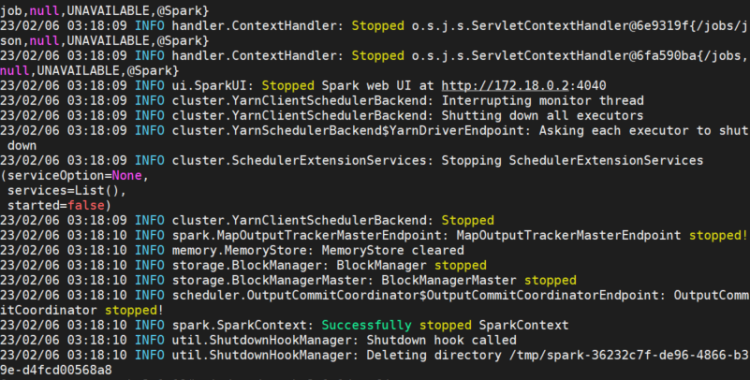

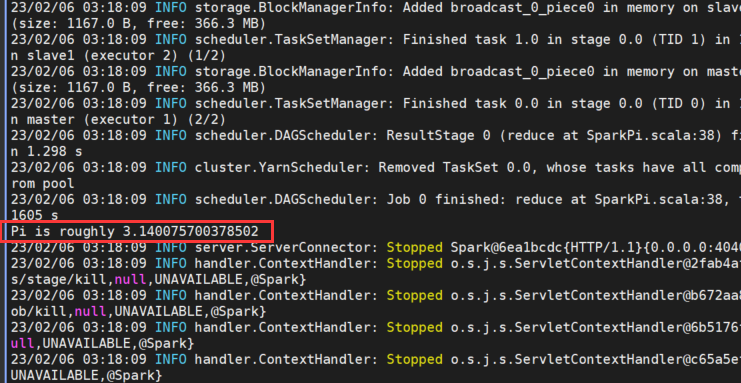

spark-submit --master yarn --class org.apache.spark.examples.SparkPi /opt/spark-2.1.1/examples/jars/spark-examples_2.11-2.1.1.jar

评论 (0)